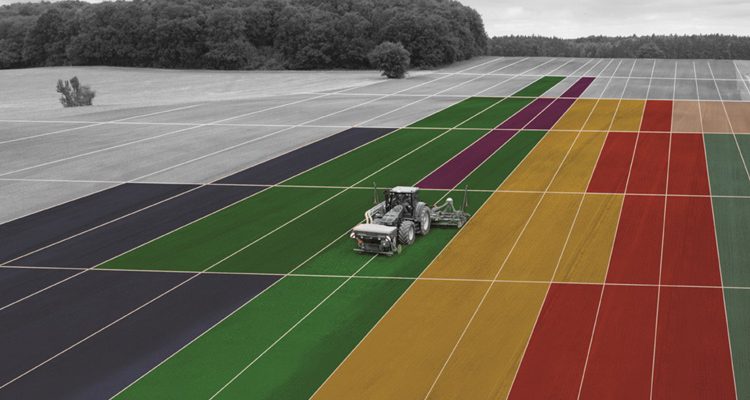

Un tractor autónomo está a punto de terminar de rociar 13,52 litros de reguladores del crecimiento de las plantas en 3,57 hectáreas de cultivos de trigo en una granja en el norte de Inglaterra. Las cifras de esta operación se registrarán mediante un sistema de software de gestión agrícola. En promedio, un solo tractor inteligente recopila alrededor de 30 MB de datos por día. Ahora, considere todas las operaciones de campo rastreadas aplicadas a numerosos cultivos en todo el Reino Unido cada año, lo que produce grandes cantidades de datos valiosos almacenados en bases de datos. A la espera de ser procesado y analizado.

¿Cómo procesamos y obtenemos información de todos estos datos, que siguen creciendo en tiempo real? Con big data.

Una solución de big data diseñada correctamente proporcionaría respuestas a una gran cantidad de consultas interesantes utilizando datos históricos y, lo que es más importante, sentaría las bases para predecir tendencias futuras.

Esta solución está siendo implementada por una empresa con sede en el Reino Unido especializada en la industria agrícola mundial, en asociación con Search Technologies.

El modelo de datos

Los datos sin procesar de los sistemas de gestión de la explotación se extraen y se ajustan a un modelo de dominio de datos que ha sido diseñado meticulosamente para facilitar su manipulación y análisis. Este proceso se llama ETL: extraer, transformar y cargar .

El modelo de datos contiene diferentes entidades, que encapsulan individualmente un concepto agrícola (productos, campos, granjas, zonas de siembra, tipos de cultivos, operaciones de campo, etc.) y se integran colectivamente para describir las actividades agrícolas.

El modelo gira en torno a las operaciones de campo, como la perforación (siembra), la protección de cultivos (aplicación de pesticidas), la nutrición (aplicación de fertilizantes) y el rendimiento de los cultivos (operaciones de cosecha).

Este modelo de datos está poblado por millones de registros para producir un lago de datos , que contiene información valiosa lista para ser consultada y descubierta.

Enriquecimientos

Los datos entrantes no solo se cargan, también se enriquecen de varias formas, por ejemplo:

Canonicalización de datos: los sistemas de gestión de la explotación a menudo permiten al agricultor escribir texto libre, que generalmente crea múltiples representaciones de la misma entidad. Por ejemplo, ‘Abc’, ‘ABC +’ y ‘ABC, 10’ se refieren al mismo pesticida. Todas estas entradas se acumularán en una única forma canónica utilizando la coincidencia de patrones con expresiones regulares.

Desglose de los componentes: Los nutrientes de los fertilizantes se pueden inferir del nombre proporcionado por el agricultor. Por ejemplo, ‘0-0-26-6’ se puede descomponer en nitrógeno (N) 0%, P2O5 (pentóxido de fósforo) 0%, K2O (óxido de potasio) 26%, SO3 (trióxido de azufre) 6%.

Composición orgánica del suelo: según la ubicación geográfica de un campo en particular, las propiedades del suelo se pueden obtener de fuentes externas.

Condiciones meteorológicas: de forma similar, las condiciones meteorológicas pasadas, así como los pronósticos para una ubicación en particular, se obtienen de una interfaz de programación de aplicaciones (API) externa.

Por lo general, los tipos de suelo y las condiciones climáticas no se almacenan dentro de los sistemas agrícolas, sin embargo, se pueden deducir de la ubicación geográfica de cada granja (latitud y longitud). Esta información proporciona nuevas y emocionantes dimensiones al lago de datos. Abre la puerta para responder potencialmente preguntas como:

«¿Qué fungicida funciona mejor en determinadas condiciones en el Reino Unido?»

«¿Deberían los agricultores considerar otras opciones para la cosecha del próximo año basándose en el clima esperado?»

Pila de tecnología

Procesamiento y almacenamiento

HPCC

HPCC (High-Performance Computer Cluster), una plataforma informática de uso intensivo de datos, ha sido elegida como la plataforma de big data para esta solución. Esta tecnología se utiliza para obtener, procesar, analizar y masajear los datos con el fin de construir el modelo de datos deseado.

HPCC tiene su propio lenguaje de programación llamado ECL (Enterprise Control Language) que fue diseñado específicamente para grandes esfuerzos de datos. ECL se utiliza dentro de THOR (The Data Refinery Cluster) , el componente de procesamiento y el sistema de archivos distribuidos de HPCC (y uno muy poderoso). THOR hace el trabajo pesado de big data de manera muy eficiente.

Consultas y búsquedas

Los requisitos técnicos de búsqueda y consulta están impulsados por casos de uso emergentes, ya que los nuevos clientes están interesados en consumir los datos almacenados en HPCC.

Entre los clientes actuales y potenciales, hay proveedores de productos, productores, cooperativas, autoridades reguladoras, distribuidores, medios de comunicación, etc., cada uno con sus propias necesidades de búsqueda, que deben analizarse caso por caso.

Sin embargo, hay dos estrategias generales implementadas actualmente:

Elasticsearch

Para buscar, navegar y dividir y cortar los datos, Elasticsearch entra en juego.

Los subconjuntos del lago de datos se envían gradualmente desde HPCC a los índices de Elasticsearch, que pueden variar en contenido y estructura, según las necesidades de búsqueda de cada caso.

La escalabilidad, la velocidad, la estabilidad y el Elastic Stack (Logstash, Kibana, X-Pack, etc.) hacen que Elasticsearch se adapte perfectamente a la arquitectura de la solución, proporcionando poder de búsqueda y facilitando los ejercicios de análisis de datos.

ROXIE (motor rápido de consultas XML en línea)

ROXIE es el motor de entrega de datos propio de HPCC. Se utiliza para exponer resultados estructurados y puntuales. Aunque diseñar e implementar las consultas puede llevar mucho tiempo, ofrece resultados muy rápidamente.

Descripción general de la arquitectura

agricultura-de-precisión-arquitectura.png

Casos de uso

API

Los datos de agricultura de precisión se pueden ofrecer a los clientes para consumo externo de manera cruda. Esto implica que el lago de datos se indexará parcial o totalmente (según los intereses de los clientes) en Elasticsearch y luego se expondrá a través de API, controladas por parámetros de consulta.

Análisis de datos y ciencia de datos

El proyecto cuenta con un equipo de ciencia de datos dedicado que examina constantemente el lago de datos para investigar consultas comerciales más complejas. Por ejemplo, preguntas más amplias como «¿Por qué 2016 fue un año terrible en términos de rendimiento de colza? ¿Qué se correlaciona con un mayor rendimiento?»

Para este escenario particular, al analizar los datos utilizando HPCC junto con software estadístico como R , el equipo de ciencia de datos puede crear un modelo estadístico con el fin de delimitar qué variables específicas entre un conjunto discreto (por ejemplo, radiación, suelo contenido, ubicación geográfica, tratamiento de fertilizantes, temperaturas, etc.) se correlacionan con un mayor rendimiento.

Esta información en particular fue solicitada por editores de una revista británica dirigida a la industria agrícola, ya que buscaban publicar el resultado de esa investigación en un próximo informe.

La respuesta a preguntas como esta y muchas otras puede ser de suma importancia para los productores, fabricantes, proveedores e incluso autoridades reguladoras, entre otros. Puede argumentar con razón que ya tienen acceso a parte de esta información, pero su consolidación, integridad y comprensión pueden ser complicadas.

Esa es la belleza de los macrodatos; le permite ver el panorama general como nunca antes lo había visto.

¿Que sigue?

La hoja de ruta es bastante prometedora. Este proyecto tiene todos los ingredientes para evolucionar rápidamente a medida que se incluyen nuevas fuentes de datos y se llama la atención de los clientes potenciales.

Incluir otros sistemas agrícolas e incorporar ganado se encuentran entre los objetivos a corto plazo, lo que aumentaría significativamente la cobertura de datos y abriría una amplia gama de nuevas posibilidades.

En su forma actual, el proyecto se encuentra en una posición favorable para entregar datos a diferentes actores de la industria siempre teniendo en cuenta un único objetivo: impulsar la productividad agrícola. Los agricultores, fabricantes, compradores, minoristas, consumidores y prácticamente cualquier persona involucrada en la cadena agrícola se beneficiarán en última instancia de la aplicación de big data a la agricultura.

De la agricultura tradicional a la agricultura con Big Data

La agricultura ha moldeado la historia de la humanidad durante siglos, desde que los primeros seres humanos domesticaron plantas y animales, y de repente se encontraron con una nueva actividad sostenible que los alentó a establecerse, desarrollar herramientas y dominar técnicas. Nació un estilo de vida. Comenzó un viaje hacia el progreso.

Como escribió HG Wells en su novela, «El mundo en libertad» (1914):

«De las acumulaciones de su labranza , de forma impremeditada, indeseada, surgió la civilización . La civilización fue el excedente agrícola » .

Podría decirse que la información es el excedente de la civilización hoy en día.

Ahora tenemos la oportunidad de unirlos para iniciar un ciclo constructivo del que todos podamos beneficiarnos.

Y eso es exactamente lo que estamos haciendo.